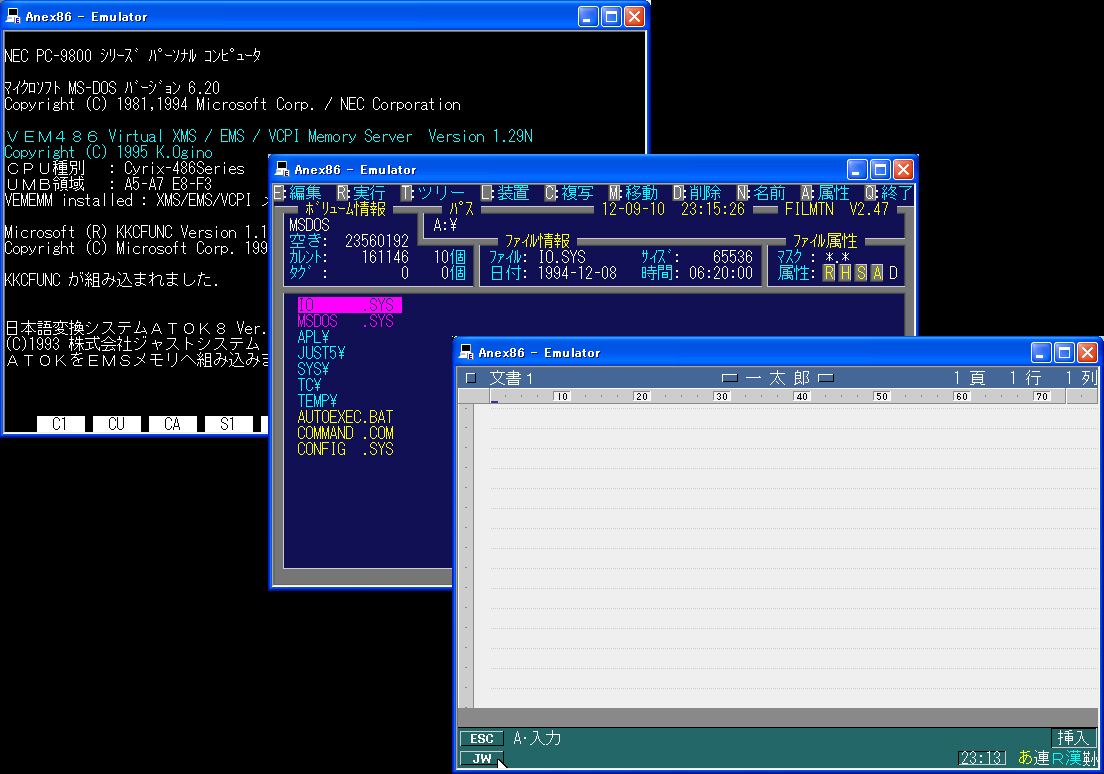

ふと、PC-9801のMSDOS環境を構築(笑) その昔、私は、EPS…

カテゴリー: ソフトウェア

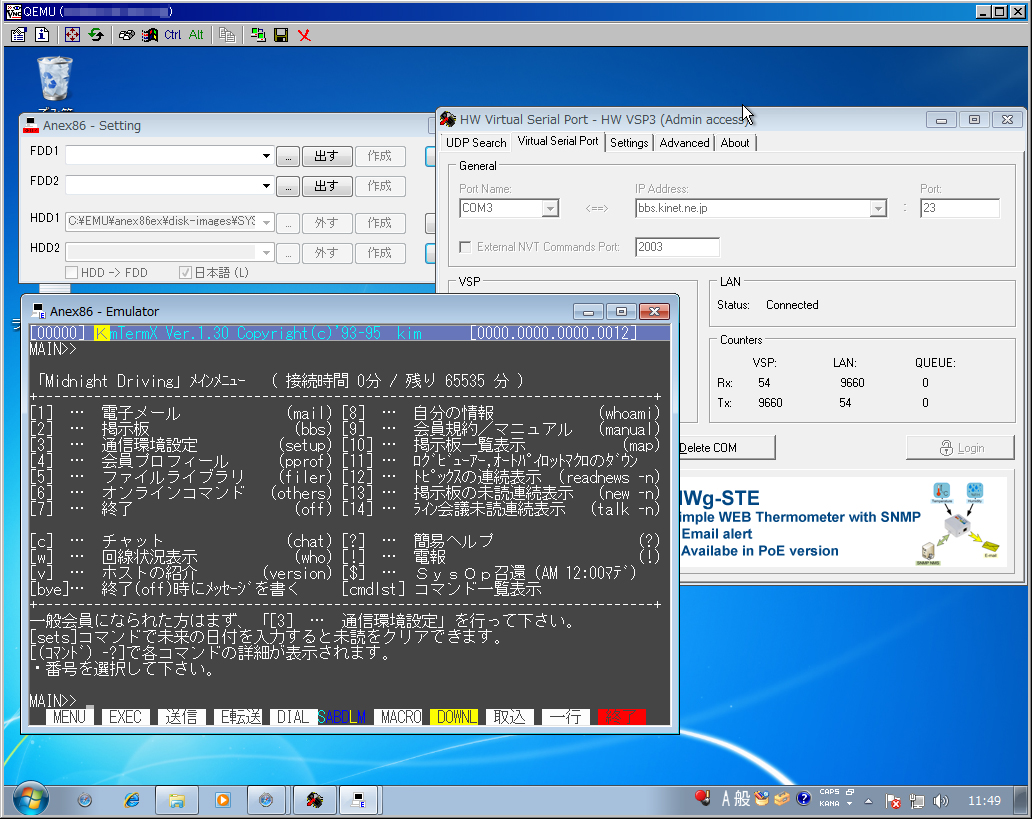

パソ通ホスト「Midnight Driving」へ98エミュレータからアクセス。

PC98エミュレータ「Anex86」をつかって、Midnight Dr…

パソ通ホスト「Midnight Driving」へiPadからアクセス。

iPadからShiftJISでtelnet出来ないかな〜とか探していた…

パソ通ホスト「Midnight Driving」をWebでもアクセスできるように・・・続編

今日の成果。 とりあえず、UNIXコマンドラインから、BASENOTE…

パソ通ホスト「Midnight Driving」をWebでもアクセスできるように・・・

夏休みの宿題と称して(笑)、パソ通ホスト「Midnight Drivi…

自宅のサーバを修理

自宅のサーバを修理しました。 どうも、最近、突然電源が落ちるので、なぜ…

Dovecotへ移行。iPhone+Becky!対策

新しくサーバを移行したタイミングで、UW-IMAPからDovecotに…

当ブログのコメントできなかったので修正ww

画像認証の調整がうまくいってなかったので、調整してみた。 たぶん、これ…

DQ67OW+SoftRAID1、カーネル落ちる。断末魔の叫び(Kernel Oops)を聞く。

kernel Oopsを取れるようになったが・・・。 2.6.39.4…

lvm2 on RAID1の構築方法。

Linuxにおける、lvm2 on RAID1の構築方法。 忘れてしま…